[Translated, TE Article] The Deciders - Sep 14th 2018

https://eoesociety.blogspot.com/2018/09/translated-te-article-coffee-carts-view_13.html

https://www.economist.com/britain/2018/09/08/funding-circle-a-british-tech-unicorn-plans-an-ipo

The Deciders

How social-media platforms dispense justice

Their armies of content moderators are expanding

printed edition | Business / Sep. 6th 2018 | MENLO PARK

EVERY other Tuesday at Facebook, and every Friday at Youtube, executives convene to debate the latest problems with hate speech, misinformation and other disturbing content on their platforms, and decide what should be removed or left alone. In San Bruno, Susan Wojcicki, YouTube's boss, personally oversees the exercise. In Menlo Park, lower-level execs run Facebook's "Content Standard Forum".

페이스북에서는 격주 목요일, 유튜브에서는 매주 금요일, 임원들은 플랫폼에 올라온 hate speech, 거짓정보, 및 기타 disturbing한 컨텐츠 관련 최신 문제들에 대해 토론하기 위해 모인다. 그리고 어떻게 제거되거나 남겨질지에 대해 결정을 한다. San Bruno에서 유튜브의 수장인 Susan Wokcicki는 직접 이활동에 대해 감독한다. Menlo 공원에서 lower-level 임원들은 페이스북의 "콘텐츠 표준 포럼"을 운영한다.

The forum has become a frequent stop on the company's publicity circuit for journalists. Its working groups recommend new guidelines on what to do about, say, a photo showing Hindu women being beaten in Bangladesh that may be inciting violence offline (take it down), a video of police brutality when race riots are taking place (leave it up), or a photo alleging that Donald Trump wore a Ku Klux Klan uniform in the 1990s (leave it up but reduce distribution of it, and inform users it's a fake). Decisions made at these meetings eventually filter down into instructions for thousands of content reviewers around the world.

이 포럼은 기자들을 위한 페이스북의 홍보회로로 자주이용되는 곳이 되었다. 실무그룹은 어떻게 대응할지에 대한 새로운 가이드라인을 추천한다. 방글라데쉬에서 힌두교 신자 여성이 얻어맞는 것을 보여주는 사진은 오프라인에서의 폭력을 조장할 수 있다 (내리기), 인종폭동이 발생했을 때의 경철의 폭력성에 관한 비디오 (남기기), 혹은 1990년에 트럼프가 KKK 유니폼을 입었다는 주장의 사진 (남겨놓지만, 배포를 줄이고, 사용자에게 거짜 뉴스라 알리기). 이러한 미팅에서 결정된 것들이 결과적으로 전세계의 수천명의 컨텐츠 검토자에게 지침으로 전달되게 된다.

Seeing how each company moderates content is encouraging. The two firms no longer regard making such decisions as a peripheral activity but as core to their business. Each employs executives who are thoughtful about the tasks of making their platforms less toxic while protecting freedom of speech. But that they do this at all is also cause for concern; they are well on their way to becoming "ministries of truth" for a global audience. Never before has such a small number of firms been able to control what billions can say and see.

어떻게 각각의 회사들이 컨텐츠를 조정하는지 보는 것은 희망적이다. 이 두개 회사들은 더이상 이러한 결정을 내리는 것은 부가적인 활동이 아니라 사업의 핵심으로서 바라본다. 두개의 회사 모두 각각 표현의 자유를 지켜주면서도 플랫폼을 덜 유해하게 만드는 일에 대해 사려가 깊은 임원들을 고용한다. 하지만, 이러한 일을 한다는 것 자체가 우려의 원인이 되기도 한다; 그들은 전세계에 청중들에게 "진실의 성직자"가 순조롭게 되어가는 중이다. 이렇게적은 수의 회사가 수십억명이 말하고 볼 수 있는 것들에 대해 통제를 하는 것은 불가능했다.

Politicians are paying ever more attention to the content these platforms carry, and to the policies they use to evaluate it. On September 5th Sheryl Sandberg, Facebook's number two, and Jack Dorsey, the boss of Twitter, testified before the Senate Select Intelligence Committee on what may be the companies' most notorious foul-up, allowing their platforms to be manipulated by Russian operatives seeking to influence the 2016 presidential election. Mr Dorsey later answered pointed questions from a House committee about content moderation. (In the first set of hearings Alphabet, the parent of Google, which also owns YouTube, was represented by an empty chair after refusing to make Larry Page, its co-founder, available.)

정치인들은 이러한 플랫폼들이 운반하는 컨텐츠들과 평가를 위해 사용하는 정책들에 점점 더 주목하고 있다. 9월 5일 Facebook의 2인자인, Sheryl Sanberg와 트위터의 수장인 Jack Dorsey는 상원 특별 정보 위원회 앞에서 이들 플랫폼이 러시아 정보원들이 2016년 대통령 선거에 영향력을 행사할 수 있도록 방치했다 혐의인, 가장 악명높은 실수에 대해 진술했다.

Mr Dorsery는 컨텐츠 조정에 관한 하원의원로부터 받은 날카로운 질문들에 대해서 이후에 답변했다. (첫번째 청문회에서 구글의 모회사이자 유튜브 또한 소유한 알파벳의 자리는 공동창업자인 Larry Page를 참석시키는데 구글이 거부하면서 공석이었다.)

Scrutiny of Facebook, Twitter, YouTube et al has intensified recently. All three faced calls to ban Alex Jones of Infowards, a conspiracy theorist; Facebook and YouTube eventually did so. At the same time the tech platforms have faced accusations of anti-conservative bias for suppressing certain news. Their loudest critic is President Donald Trump, who has threatened (via Twitter) to regulate them. Straight after the hearings, Jeff Sessions, his attorney-general, said that he would discuss with states' attorney-general the "growing concern" that the platforms are hurting competition and stifling the free exchange of ideas.

Facebook, Twitter, YouTube 등에 대한 조사는 최근 강화됐다. 세 기업 모두 음모론자인, Infowars의 Alex Jones를 추방하라는 요청에 직면했다. 동시에 기술기업들은 특정 뉴스를 억압하는 반보수적 편향성에 관한 비난에 직면하기도 했다. 가장 시끄러운 비판론자는 트럼프 대통령이다, 그는 (트워터를 통해) 그들을 규제할것이라 협박했다. 청문회 직후에, 법무부 장관인 Jeff Sessions는 트럼프 대통령이 Jeff Sessions와 플랫폼들이 경쟁을 훼손하고 자유로운 생각의 교류를 억압한다는 "커져가는 우려"에 대해 논의할 것이라고 언급했다.

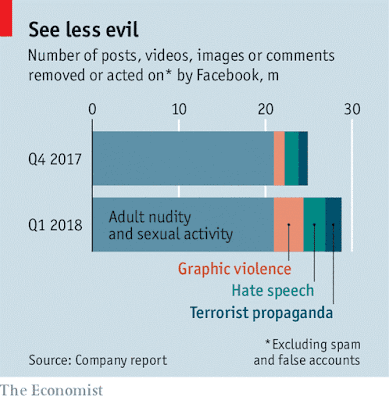

Although most of the moderators work for third-party firms, the growth in their numbers has already had an impact on the firms’ finances. When Facebook posted disappointing quarterly results in July, causing its market capitalisation to drop by over $100bn, higher costs for moderation were partly implicated. Mark Zuckerberg, the firm’s chief executive, has said that in the long run the problem of content moderation will have to be solved with artificial intelligence (AI). In the first three months of 2018 Facebook took some form of action on 7.8m pieces of content that included graphic violence, hate speech or terrorist propaganda, twice as many as in the previous three months (see chart), mostly owing to improvements in automated detection. But moderating content requires wisdom, and an algorithm is only as judicious as the principles with which it is programmed.

https://eoesociety.blogspot.com/2018/09/translated-te-article-coffee-carts-view_13.html

https://www.economist.com/britain/2018/09/08/funding-circle-a-british-tech-unicorn-plans-an-ipo

The Deciders

How social-media platforms dispense justice

Their armies of content moderators are expanding

printed edition | Business / Sep. 6th 2018 | MENLO PARK

EVERY other Tuesday at Facebook, and every Friday at Youtube, executives convene to debate the latest problems with hate speech, misinformation and other disturbing content on their platforms, and decide what should be removed or left alone. In San Bruno, Susan Wojcicki, YouTube's boss, personally oversees the exercise. In Menlo Park, lower-level execs run Facebook's "Content Standard Forum".

페이스북에서는 격주 목요일, 유튜브에서는 매주 금요일, 임원들은 플랫폼에 올라온 hate speech, 거짓정보, 및 기타 disturbing한 컨텐츠 관련 최신 문제들에 대해 토론하기 위해 모인다. 그리고 어떻게 제거되거나 남겨질지에 대해 결정을 한다. San Bruno에서 유튜브의 수장인 Susan Wokcicki는 직접 이활동에 대해 감독한다. Menlo 공원에서 lower-level 임원들은 페이스북의 "콘텐츠 표준 포럼"을 운영한다.

The forum has become a frequent stop on the company's publicity circuit for journalists. Its working groups recommend new guidelines on what to do about, say, a photo showing Hindu women being beaten in Bangladesh that may be inciting violence offline (take it down), a video of police brutality when race riots are taking place (leave it up), or a photo alleging that Donald Trump wore a Ku Klux Klan uniform in the 1990s (leave it up but reduce distribution of it, and inform users it's a fake). Decisions made at these meetings eventually filter down into instructions for thousands of content reviewers around the world.

이 포럼은 기자들을 위한 페이스북의 홍보회로로 자주이용되는 곳이 되었다. 실무그룹은 어떻게 대응할지에 대한 새로운 가이드라인을 추천한다. 방글라데쉬에서 힌두교 신자 여성이 얻어맞는 것을 보여주는 사진은 오프라인에서의 폭력을 조장할 수 있다 (내리기), 인종폭동이 발생했을 때의 경철의 폭력성에 관한 비디오 (남기기), 혹은 1990년에 트럼프가 KKK 유니폼을 입었다는 주장의 사진 (남겨놓지만, 배포를 줄이고, 사용자에게 거짜 뉴스라 알리기). 이러한 미팅에서 결정된 것들이 결과적으로 전세계의 수천명의 컨텐츠 검토자에게 지침으로 전달되게 된다.

Seeing how each company moderates content is encouraging. The two firms no longer regard making such decisions as a peripheral activity but as core to their business. Each employs executives who are thoughtful about the tasks of making their platforms less toxic while protecting freedom of speech. But that they do this at all is also cause for concern; they are well on their way to becoming "ministries of truth" for a global audience. Never before has such a small number of firms been able to control what billions can say and see.

어떻게 각각의 회사들이 컨텐츠를 조정하는지 보는 것은 희망적이다. 이 두개 회사들은 더이상 이러한 결정을 내리는 것은 부가적인 활동이 아니라 사업의 핵심으로서 바라본다. 두개의 회사 모두 각각 표현의 자유를 지켜주면서도 플랫폼을 덜 유해하게 만드는 일에 대해 사려가 깊은 임원들을 고용한다. 하지만, 이러한 일을 한다는 것 자체가 우려의 원인이 되기도 한다; 그들은 전세계에 청중들에게 "진실의 성직자"가 순조롭게 되어가는 중이다. 이렇게적은 수의 회사가 수십억명이 말하고 볼 수 있는 것들에 대해 통제를 하는 것은 불가능했다.

Politicians are paying ever more attention to the content these platforms carry, and to the policies they use to evaluate it. On September 5th Sheryl Sandberg, Facebook's number two, and Jack Dorsey, the boss of Twitter, testified before the Senate Select Intelligence Committee on what may be the companies' most notorious foul-up, allowing their platforms to be manipulated by Russian operatives seeking to influence the 2016 presidential election. Mr Dorsey later answered pointed questions from a House committee about content moderation. (In the first set of hearings Alphabet, the parent of Google, which also owns YouTube, was represented by an empty chair after refusing to make Larry Page, its co-founder, available.)

정치인들은 이러한 플랫폼들이 운반하는 컨텐츠들과 평가를 위해 사용하는 정책들에 점점 더 주목하고 있다. 9월 5일 Facebook의 2인자인, Sheryl Sanberg와 트위터의 수장인 Jack Dorsey는 상원 특별 정보 위원회 앞에서 이들 플랫폼이 러시아 정보원들이 2016년 대통령 선거에 영향력을 행사할 수 있도록 방치했다 혐의인, 가장 악명높은 실수에 대해 진술했다.

Mr Dorsery는 컨텐츠 조정에 관한 하원의원로부터 받은 날카로운 질문들에 대해서 이후에 답변했다. (첫번째 청문회에서 구글의 모회사이자 유튜브 또한 소유한 알파벳의 자리는 공동창업자인 Larry Page를 참석시키는데 구글이 거부하면서 공석이었다.)

Scrutiny of Facebook, Twitter, YouTube et al has intensified recently. All three faced calls to ban Alex Jones of Infowards, a conspiracy theorist; Facebook and YouTube eventually did so. At the same time the tech platforms have faced accusations of anti-conservative bias for suppressing certain news. Their loudest critic is President Donald Trump, who has threatened (via Twitter) to regulate them. Straight after the hearings, Jeff Sessions, his attorney-general, said that he would discuss with states' attorney-general the "growing concern" that the platforms are hurting competition and stifling the free exchange of ideas.

Facebook, Twitter, YouTube 등에 대한 조사는 최근 강화됐다. 세 기업 모두 음모론자인, Infowars의 Alex Jones를 추방하라는 요청에 직면했다. 동시에 기술기업들은 특정 뉴스를 억압하는 반보수적 편향성에 관한 비난에 직면하기도 했다. 가장 시끄러운 비판론자는 트럼프 대통령이다, 그는 (트워터를 통해) 그들을 규제할것이라 협박했다. 청문회 직후에, 법무부 장관인 Jeff Sessions는 트럼프 대통령이 Jeff Sessions와 플랫폼들이 경쟁을 훼손하고 자유로운 생각의 교류를 억압한다는 "커져가는 우려"에 대해 논의할 것이라고 언급했다.

Protected species

보호종

보호종

This turn of events signals the ebbing of a longstanding special legal protection for the companies. Internet firms in America are shielded from legal responsibility for content posted on their services. Section 230 of the Communications Decency Act of 1996 treats them as intermediaries, not publishers—to protect them from legal jeopardy.

이벤트들의 이러한 전환은 이러한 회사들에 대해 오래된 특별 법적 보호의 약화를 의미한다. 미국의 인터넷 회사들은 서비스에 게시된 컨텐트에 대한 법적 책임으로부터 보호받고 있다. 1996년의 통신품위법의 Section 230에 법적인 위기로부터 보호하기 위해 출판인이 아닌 중개기관으로 이러한 회사들을 취급했다.

When the online industry was limited to young, vulnerable startups this approach was reasonable. A decade ago content moderation was a straightforward job. Only 100m people used Facebook and its community standards fitted on two pages. But today there are 2.2bn monthly users of Facebook and 1.9bn monthly logged-on users of YouTube. They have become central venues for social interaction and for all manner of expression, from lucid debate and cat videos to conspiracy theories and hate speech.

온라인 업계가 업력이 짧고, 취약한 스타트업들로만 제한됐을때, 이러한 접근은 합당했다. 10년 전에 컨텐트 변경은 단순한 일이었다. 1억명만이 페이스북을 사용했고, 커뮤니티 표준은 2페이지 정도 분량에 적합했다. 하지만 오늘날 페이스북은 월간 22억명의 사용자가 있고, 유튜브는 월간 19억명의 접속 사용자가 있다. 이들의 플랫폼은명쾌한 토론과 고양이 영상부터 음모론과 편파적 발언까지 온갖 종류의 표현수단과 사회적 상호관계의 중심지가 되었다.

At first social-media platforms failed to adjust to the magnitude and complexity of the problems their growth and power were creating, saying that they did not want to be the “arbiters of truth”. Yet repeatedly in recent years the two companies, as well as Twitter, have been caught flat-footed by reports of abuse and manipulation of their platforms by trolls, hate groups, conspiracy theorists, misinformation peddlers, election meddlers and propagandists. In Myanmar journalists and human-rights experts found that misinformation on Facebook was inciting violence against Muslim Rohyinga. In the aftermath of a mass shooting at a school in Parkland, Florida, searches about the shooting on YouTube surfaced conspiracy videos alleging it was a hoax involving “crisis actors”. 처음에는 소셜미디어 플랫폼들은 “진실의 중재자”가 되질 원하지 않는다고 언급하며, 그들의 성장과 영향력이 만들어내는 문제들에 대한 크기와 복잡함에 대해 적응에 실패했다. 하지만 반복적으로 최근 몇 년간, 트위터 뿐만 아니라 이들 두개의 회사는 트롤, 혐오단체, 음모론, 잘못된 정보를 퍼나르는 사람, 선거에 간섭하려는 사람들, 선전원들에 의한 플랫폼의 조작과 남용에 대한 보고들에 의해 꼼짝없이 당했다.플로리다 파크랜드의 한 학교에서 일어난 대규모 총격사건의 여파로 유튜브에서 총격을 검색하면 “위기 배우(crisis actor, 비상훈련과 같은 모의 상황에서 재난 피해자를 연기하는 사람)”를 포함하는 거짓말이라 주장하는 음모론 영상이 나타난다.

In reaction, Facebook and YouTube have sharply increased the resources, both human and technological, dedicated to policing their platforms. By the end of this year Facebook will have doubled the number of employees and contractors dedicated to the “safety and security” of the site, to 20,000, including 10,000 content reviewers. YouTube will have 10,000 people working on content moderation in some form. They take down millions of posts every month from each platform, guided by thick instruction manuals—the guidelines for “search quality” evaluators at Google, for example, run to 164 pages.

이에 대한 반응으로, 페이스북과 유튜브는 플랫폼 감시에 투입되는 인적, 기술적 양 측면 모두에서 투입 리소스를 증가시켰다. 올해 말까지, 페이스북은 사이트의 "안정성 및 보안성"을 위한 종업원 및 계약직의 수를 2만명까지 두배로 늘릴 것이다. 이들 중에는 만명의 컨텐츠 검토자들도 포함된다. 유튜브는 동일한 형태로 컨텐츠 조정에 만명을 투입할 것이다. 구글과 페이스북은 각자의 플랫폼에서 매달 수백만의 게시물들을 삭제하고, 이것들은 두꺼운 지시 메뉴얼에 따른다—예를 들어, 구글의 "검색 품질" 평가자들을 위한 가이드라인은 164페이지에 이른다. 비록 대부분의 조정자들이 외부업체에서 일하지만, 이들 숫자의 성장은 구글과 페이스북의 재정에 이미 영향력을 끼쳐왔다. 페이스북이 7월에 실망스러운 분기결과를 보고하면서 시가총액이 천억달러 넘게 떨어졌을때, 높은 조정비용이 일부 연관되었다. 페이스북의 대표인 마크 주커버그는 장기적으로 컨텐츠 조정 문제는 AI에 의해 해결될 것이라고 밝혔다. 2018년 1분기에 페이스북은 폭력영상, 경멸적 발언, 혹은 테러리스트 선동을 포함하는 7백8십만 개의 컨텐츠에 대해 특정형태에 조치를 취했다. 이 컨텐츠 개수는 직전 분기의 2배였고 (차트 참조), 대체ㅔ로 자동화된 탐색에서의 향상 덕분이었다. 하지만 컨텐츠 조정은 지혜를 요구하고, 알고리즘은 프로그래밍 시 적용된 원칙만큼만 신중하게 되어있다.

At Facebook’s headquarters in Menlo Park, executives instinctively resist making new rules restricting content on free-speech grounds. Many kinds of hateful, racist comments are allowed, because they are phrased in such a way as to not specifically target a race, religion or other protected group. Or perhaps they are jokes.

Menlo Park에 있는 페이스북 본부에서 임원들은 직관적으로 표현의 자유가 보장된 장소에 올라온 컨텐츠들을 규제하는 새로운 규정을 만드는 것에 반대한다. 많은 혐오적이고, 인종차별적인 커멘트들이 특정 인종, 종교 혹은 보호받는 집단을 겨냥하지 않는 방법으로 표현되기 때문에 허용된다.

Fake news poses different questions. “We don’t remove content just for being false,” says Monika Bickert, the firm’s head of product policy and counterterrorism. What Facebook can do, instead of removing material, she says, is “down-rank” fake news flagged by external fact-checkers, meaning it would be viewed by fewer people, and show real information next to it. In hot spots like Myanmar and Sri Lanka, where misinformation has inflamed violence, posts may be taken down.

가짜뉴스는 다른 문제를 제기한다. "틀렸다고 해서 켄텐츠를 지우지는 않는다." 페이스북의 상품정책 및 테러리스트방지 수장인 Monika Bickert는 말한다. 자료를 지우는 것 대신에 페이스북이 할 수 있는 일은, 그녀에 따르면, 외부 팩트체커가 표시한 가짜류스에 대해 "등급을 내리는 것"이다. 이는 더 적은 수의 사람들이 이 컨텐츠들을 보게 되고 옆에 실제 정보를 보여주는 것을 의미한다. 잘못된 정보가 폭력을 촉발했던 미얀마와 스리랑카와 같은 분쟁지대에서 게시글은 내려질 수 있다.

가짜뉴스는 다른 문제를 제기한다. "틀렸다고 해서 켄텐츠를 지우지는 않는다." 페이스북의 상품정책 및 테러리스트방지 수장인 Monika Bickert는 말한다. 자료를 지우는 것 대신에 페이스북이 할 수 있는 일은, 그녀에 따르면, 외부 팩트체커가 표시한 가짜류스에 대해 "등급을 내리는 것"이다. 이는 더 적은 수의 사람들이 이 컨텐츠들을 보게 되고 옆에 실제 정보를 보여주는 것을 의미한다. 잘못된 정보가 폭력을 촉발했던 미얀마와 스리랑카와 같은 분쟁지대에서 게시글은 내려질 수 있다.

YouTube’s moderation system is similar to Facebook’s, with published guidelines for what is acceptable and detailed instructions for human reviewers. Human monitors decide quickly what to do with content that has been flagged, and most such flagging is done via automated detection. Twitter also uses AI to sniff out fake accounts and some inappropriate content, but it relies more heavily on user reports of harassment and bullying.

유튜브의 조정 시스템은 무엇이 수용가능한지에 대한 공개된 가이드라인과 검토인력을 위한 상세한 지시사항과 함께 페이스북의 시스템과 유사하다. 모니터링 요원들은 재빨리 표시된 컨텐츠에 무엇을 할지 결정하고, 이러한 표시의 대부분은 자동화된 탐색에 의해 이루어진다. 트위터도 또한 가짜 계정과 부적절한 컨텐츠를 찾아내는 AI를 사용한다. 하지만 괴롭힘에 관한 사용자의 보고에 더 많이 의존한다.

As social-media platforms police themselves, they will change. They used to be, and still see themselves as, lean and mean, keeping employees to a minimum. But Facebook, which has about 25,000 people on its payroll, is likely soon to keep more moderators busy than it has engineers. It and Google may be rich enough to absorb the extra costs and still prosper. Twitter, which is financially weaker, will suffer more.

소셜미디어 플랫폼 스스로를 감시하면서, 플랫폼들은 변했다. 과거에 그리고 지금도 종업원들의 수를 최소로 유지하면서 스스로를 lean하고(가볍고) mean(인색)한 조직이라 여겼다. 하지만 급여 대상자 명단에 약 2만 5천명을 보유한 페이스북은 곧 더 많은 조정자들을 엔지니어들보다 바쁘게 유지할 가능성이 높다. 페이스북과 구글은 초과비용을 감당하면서도 여전히 번영하기에 충분할 정도로 부유하다. 금융적으로 상대적으로 취약한 트위터는 좀 더 많이 고통스러울 것이다.

소셜미디어 플랫폼 스스로를 감시하면서, 플랫폼들은 변했다. 과거에 그리고 지금도 종업원들의 수를 최소로 유지하면서 스스로를 lean하고(가볍고) mean(인색)한 조직이라 여겼다. 하지만 급여 대상자 명단에 약 2만 5천명을 보유한 페이스북은 곧 더 많은 조정자들을 엔지니어들보다 바쁘게 유지할 가능성이 높다. 페이스북과 구글은 초과비용을 감당하면서도 여전히 번영하기에 충분할 정도로 부유하다. 금융적으로 상대적으로 취약한 트위터는 좀 더 많이 고통스러울 것이다.

More profound change is also possible. If misinformation, hate speech and offensive content are so pervasive, critics say, it is because of the firms’ business model: advertising. To sell more and more ads, Facebook’s algorithms, for instance, have favoured “engaging” content, which can often be the bad kind. YouTube keeps users on its site by offering them ever more interesting videos, which can also be ever more extreme ones. In other words, to really solve the challenge of content moderation, the big social-media platforms may have to say goodbye to the business model which made them so successful.

더 심도깊은 변화 또한 가능하다. 만약 부정확한 정보, 편파적 발언과 공격적인 컨텐츠가 너무 만연하다면, 비판론자들이 말하는 것처럼, 그것은 이들기업의 비즈니스 모델: 광고 때문이다. 더욱 많은 광고를 판매하기 위하여, 페이스북의 알고리즘은, 예를 들면, "매력적인" 컨텐츠를 선호했다. 이러한 컨텐츠는 종종 나쁜 종류가 될 수 있다. 유튜브는 극단적일 수 있는 항상 흥미로운 비디오를 제공함으로써 사용자들이 사이트에 지속적으로 머무르도록 한다. 다시 말하자면, 컨텐츠 조정이라는 과제를 진정으로 해결하기 위해서는, 거대 소셜미디어 플랫폼들이 스스로를 엄청나게 성공적이게 만든 비즈니스 모델에 작별을 선고해야 할 수있다.https://eoesociety.blogspot.com/2018/09/translated-te-article-coffee-carts-view_13.html

Comments

Post a Comment